**Átomo**

El átomo es un

constituyente materia ordinaria, con propiedades químicas bien definidas, que

mantiene su identidad. Cada elemento químico está formado por átomos del mismo

tipo (con la misma estructura electrónica básica), y que no es posible dividir

mediante procesos químicos. Está compuesto por un núcleo atómico, en el que se

concentra casi toda su masa, rodeado de una nube de electrones. El núcleo está

formado por protones, con carga positiva, y neutrones, eléctricamente neutros.

Los electrones, cargados negativamente, permanecen ligados a este mediante la

fuerza electromagnética.

Los átomos se

clasifican de acuerdo al número de protones y neutrones que contenga su núcleo.

El número de protones o número atómico determina su elemento químico, y el

número de neutrones determina su isótopo. Un átomo con el mismo número de

protones que de electrones es eléctricamente neutro. Si por el contrario posee

un exceso de protones o de electrones, su carga neta es positiva o negativa, y

se denomina ion.

El nombre «átomo» proviene del latín «atomum»,

y este del griego «ἄτομον», «sin partes»; también, se deriva de «a» (no) y

«tomo» (divisible); no divisible.1 El concepto de átomo como bloque básico e

indivisible que compone la materia del universo fue postulado por la escuela

atomista en la Antigua Grecia. Sin embargo, su existencia no quedó demostrada

hasta el siglo XIX. Con el desarrollo de la física nuclear en el siglo XX se

comprobó que el átomo puede subdividirse en partículas más pequeñas.

La parte

central del átomo, el núcleo atómico, tiene una carga positiva en la que se

concentra casi toda su masa mientras que en la corteza, alrededor del núcleo

atómico, hay un cierto número de electrones, que son unas partículas cargadas

negativamente.

PARTÍCULAS SUBATÓMICAS

A pesar de que átomo significa

‘indivisible’, en realidad está formado por varias partículas subatómicas. El

átomo contiene protones, neutrones y electrones, con la excepción del

hidrógeno-1, que no contiene neutrones, y del catión hidrógeno o hidrón, que no

contiene electrones. Los protones y neutrones del átomo se denominan nucleones,

por formar parte del núcleo atómico.

El electrón es la partícula más

ligera de cuantas componen el átomo, con una masa de 9,11 · 10−31 kg. Tiene una

carga eléctrica negativa, cuya magnitud se define como la carga eléctrica

elemental, y se ignora si posee subestructura, por lo que se lo considera una

partícula elemental. Los protones tienen una masa de 1,67 · 10−27 kg, 1836

veces la del electrón, y una carga positiva opuesta a la de este. Los neutrones

tienen un masa de 1,69 · 10−27 kg, 1839 veces la del electrón, y no poseen

carga eléctrica. Las masas de ambos nucleones son ligeramente inferiores dentro

del núcleo, debido a la energía potencial del mismo; y sus tamaños son

similares, con un radio del orden de 8 · 10-16 m o 0,8 femtómetros (fm).4

El protón y el neutrón no son partículas

elementales, sino que constituyen un estado ligado de quarks u y d, partículas

fundamentales recogidas en el modelo estándar de la física de partículas, con

cargas eléctricas iguales a +2/3 y −1/3 respectivamente, respecto de la carga

elemental. Un protón contiene dos quarks u y un quark d, mientras que el

neutrón contiene dos d y un u, en consonancia con la carga de ambos. Los quarks

se mantienen unidos mediante la fuerza nuclear fuerte, mediada por gluones —del

mismo modo que la fuerza electromagnética está mediada por fotones—. Además de

estas, existen otras partículas subatómicas en el modelo estándar: más tipos de

quarks, leptones cargados (similares al electrón), etc.

NUBE DE ELECTRONES

Los electrones en el átomo son

atraídos por los protones a través de la fuerza electromagnética. Esta fuerza

los atrapa en un pozo de potencial electrostático alrededor del núcleo, lo que

hace necesaria una fuente de energía externa para liberarlos. Cuanto más cerca

está un electrón del núcleo, mayor es la fuerza atractiva, y mayor por tanto la

energía necesaria para que escape.

***CUANTOS***

En física, el término cuanto o

cuantio (del latín Quantum, plural Quanta, que representa una cantidad de algo)

denotaba en la física cuántica primitiva tanto el valor mínimo que puede tomar

una determinada magnitud en un sistema físico, como la mínima variación posible

de este parámetro al pasar de un estado discreto a otro.1 Se hablaba de que una

determinada magnitud estaba cuantizada según el valor de cuanto. Es decir,

cuanto es una proporción hecha por la magnitud dada.

Un ejemplo del modo en que

algunas cantidades relevantes de un sistema físico están cuantizadas lo

encontramos en el caso de la carga eléctrica de un cuerpo, que sólo puede tomar

un valor que sea un múltiplo entero de la carga del electrón. En la moderna

teoría cuántica aunque se sigue hablando de cuantización el término cuanto ha

caído en desuso. El hecho de que las magnitudes estén cuantizadas se considera

ahora un hecho secundario y menos definitorio de las caracterísitcas esenciales

de la teoría.

En informática, un cuanto de

tiempo es un pequeño intervalo de tiempo que se asigna a un proceso para que

ejecute sus instrucciones. El cuanto es determinado por el planificador de

procesos utilizando algún algoritmo de planificación.

EXPLICACIÓN CIENTÍFICA DEL CONCEPTO

DEL CUANTO DE ENERGÍA

Durante más de dos siglos la física newtoniana

resultó válida para describir todos los fenómenos concernientes a materia y

energía. Después, en el siglo XIX, la teoría electromagnética reveló que la

energía podía existir con cierta independencia de la materia, en forma de

radiaciones de muy diferentes longitudes de onda y frecuencias. Al mismo

tiempo, el estudio de la termodinámica abordó problemas suscitados por la

energía calorífica y su distribución en sistemas como los gases, cuyas

partículas resultaban demasiado pequeñas para ser medidas u observadas.

Era imposible —y afortunadamente

innecesario— predecir el comportamiento de cada molécula o de cada átomo, pero

las leyes estadísticas de la probabilidad podían aplicarse a grandes conjuntos

de partículas, dentro de una reducida muestra o sistema.

En un gas, a determinada

temperatura, unas moléculas se mueven muy lentamente y otras con gran

celeridad: sin embargo, la energía media de todas las moléculas en movimiento

depende exclusivamente de la temperatura y de la presión a que dicho gas esté

sometido si el volumen es constante. Max Planck fue uno de los muchos

científicos que trataron de aplicar los principios de

la

termodinámica a las radiaciones.

Para fines del siglo XIX, se

sabía que la radiación de cuerpo negro se debía a las oscilaciones de las

partículas cargadas de la superficie de estos cuerpos. Sin embargo, a partir

del electromagnetismo clásico era imposible deducir los espectros y las leyes

experimentales de Stefan-Boltzmann y de Wien. La Física clásica había llegado a

un límite que no podría superar.

Un científico alemán llamado Max

Planck (1858-1947) fue el responsable de introducir una innovación que

cambiaría para siempre el rumbo de la Física.

Probando distintas funciones y haciendo infinidad de cálculos, Planck

había encontrado (sin deducirla de principios de la Física) una fórmula que

describía muy bien los espectros experimentales de los

Cuerpos

negros. Pero encontrar la forma funcional de una relación no significa explicar

por qué resulta así. Esta fórmula se resistía a ser deducida de los principios

clásicos. Entonces Planck, sin demasiado convencimiento, se vio obligado a

introducir un postulado que no tenía, en principio, ninguna justificación, pero

que le permitía predecir perfectamente los espectros de radiación que la

naturaleza mostraba. Era el siguiente:

Los osciladores microscópicos

responsables de la emisión electromagnética no pueden emitir o absorber

cualquier valor de energía. Si el oscilador tiene frecuencia y, sólo emitirá o

absorberá múltiplos enteros del cuanto de energía E = h . v (donde h es la

constante de Planck).

**RELATIVIDAD**

La teoría de la relatividad está

compuesta a grandes rasgos por dos grandes teorías (la de la relatividad

especial y la de la relatividad general) formuladas por Albert Einstein a

principios del siglo XX, que pretendían resolver la incompatibilidad existente

entre la mecánica newtoniana y el electromagnetismo.

La primera teoría, publicada en 1905, trata de

la física del movimiento de los cuerpos en ausencia de fuerzas gravitatorias,

en el que se hacían compatibles las ecuaciones de Maxwell del electromagnetismo

con una reformulación de las leyes del movimiento. La segunda, de 1915, es una

teoría de la gravedad que reemplaza a la gravedad newtoniana pero coincide

numéricamente con ella en campos gravitatorios débiles. La teoría general se

reduce a la teoría especial en ausencia de campos gravitatorios.

No fue hasta el 7 de marzo de 2010 cuando

fueron mostrados públicamente los manuscritos originales de Einstein por parte

de la Academia Israelí de Ciencias, aunque la teoría se había publicado en

1905. El manuscrito tiene 46 páginas de textos y fórmulas matemáticas

redactadas a mano, y fue donado por Einstein a la Universidad Hebrea de

Jerusalén en 1925 con motivo de su

>>RELATIVIDAD ESPECIAL

La teoría de la relatividad

especial, también llamada teoría de la relatividad restringida, publicada por

Albert Einstein en 1905, describe la física del movimiento en el marco de un

espacio-tiempo plano, describe correctamente el movimiento de los cuerpos

incluso a grandes velocidades y sus interacciones electromagnéticas y se usa

básicamente para estudiar sistemas de referencia inerciales. Estos conceptos

fueron presentados anteriormente por Poincaré y Lorentz, que son considerados

como originadores de la teoría. Si bien la teoría resolvía un buen número de

problemas del electromagnetismo y daba una explicación del experimento de

Michelson-Morley, esta teoría no proporciona una descripción relativista del

campo gravitatorio.

Tras la publicación del artículo de Einstein,

la nueva teoría de la relatividad especial fue aceptada en unos pocos años por

la práctica totalidad de los físicos y los matemáticos, de hecho personas como

Poincaré o Lorentz habían estado muy cerca de llegar al mismo resultado que

Einstein. La forma geométrica definitiva de la teoría se debe a Hermann

Minkowski, antiguo profesor de Einstein en la Politécnica de Zürich; acuñó el

término "espacio-tiempo" (Raumzeit) y le dio la forma matemática

adecuada.4 El espacio-tiempo de Minkowski es una variedad tetradimensional en

la que se entrelazaban de una manera insoluble las tres dimensiones espaciales

y el tiempo. En este espacio-tiempo de Minkowski, el movimiento de una

partícula se representa mediante su línea de universo (Weltlinie), una curva

cuyos puntos vienen determinados por cuatro variables distintas: las tres

dimensiones espaciales (,,) y el tiempo (). El nuevo esquema de Minkowski

obligó a reinterpretar los conceptos de la métrica existentes hasta entonces.

El concepto tridimensional de punto fue sustituido por el de evento. La

magnitud de distancia se reemplaza por la magnitud de intervalo.

La relatividad general fue

publicada por Einstein en 1915, y fue presentada como conferencia en la

Academia de Ciencias Prusiana el 25 de noviembre. La teoría generaliza el

principio de relatividad de Einstein para un observador arbitrario. Esto

implica que las ecuaciones de la teoría deben tener una forma de covariancia

más general que la covariancia de Lorentz usada en la teoría de la relatividad

especial. Además de esto, la teoría de la relatividad general propone que la

propia geometría del espacio-tiempo se ve afectada por la presencia de materia,

de lo cual resulta una teoría relativista del campo gravitatorio. De hecho la teoría

de la relatividad general predice que el espacio-tiempo no será plano en

presencia de materia y que la curvatura del espacio-tiempo será percibida como

un campo gravitatorio.

La relatividad general fue

publicada por Einstein en 1915, y fue presentada como conferencia en la

Academia de Ciencias Prusiana el 25 de noviembre. La teoría generaliza el

principio de relatividad de Einstein para un observador arbitrario. Esto

implica que las ecuaciones de la teoría deben tener una forma de covariancia

más general que la covariancia de Lorentz usada en la teoría de la relatividad

especial. Además de esto, la teoría de la relatividad general propone que la

propia geometría del espacio-tiempo se ve afectada por la presencia de materia,

de lo cual resulta una teoría relativista del campo gravitatorio. De hecho la teoría

de la relatividad general predice que el espacio-tiempo no será plano en

presencia de materia y que la curvatura del espacio-tiempo será percibida como

un campo gravitatorio.

Debe notarse que el matemático alemán David

Hilbert escribió e hizo públicas las ecuaciones de la covarianza antes que

Einstein. Ello resultó en no pocas acusaciones de plagio contra Einstein, pero

probablemente sea más, porque es una teoría (o perspectiva) geométrica. La

misma postula que la presencia de masa o energía «curva» al espacio-tiempo, y

esta curvatura afecta la trayectoria de los cuerpos móviles e incluso la

trayectoria de la luz.

Einstein expresó el propósito de la teoría de

la relatividad general para aplicar plenamente el programa de Ernst Mach de la

relativización de todos los efectos de inercia, incluso añadiendo la llamada

constante cosmológica a sus ecuaciones de campo5 para este propósito. Este

punto de contacto real de la influencia de Ernst Mach fue claramente

identificado en 1918, cuando Einstein distingue lo que él bautizó como el

principio de Mach (los efectos inerciales se derivan de la interacción de los

cuerpos) del principio de la relatividad general, que se interpreta ahora como

el principio de covarianza general.

problemas resueltos***

!..¡Cuál ha de ser la velocidad relativa de dos observadores inerciales

para que sus medidas de intervalos de tiempo difieran en 1% ?

Cambiando a un sistema fijo en la nave1 (V=0.9c), tenemos

El cálculo de v’2 dará directamente la velocidad relativa entre las naves

3...Sea un tren que camina a una velocidad V con respecto a la Tierra. Sobre los extremos del tren caen rayos que dejan marcas P’ y Q’ sobre él, y P y Q sobre la Tierra. Un observador O que esté sobre la Tierra a mitad de camino entre P y Q ve caer los rayos en forma simultánea. Indicar si ocurrirá o no lo propio para un observador O’ situado en el punto medio del tren (ejemplo propuesto por Einstein).

Solución:

Lo primero que hay que hacer es fijar los sistemas de referencia. Arbitrariamente indicamos como fijo al del observador en la Tierra.

Como para este observador (O) el tren está en movimiento, su longitud está contraída

La longitud del tren para O será:

Para O los rayos caen simultáneamente, es decir t1= t2 , y están separados por la distancia l (longitud contraída del tren).

Para O’ los rayos no caen simultáneamente.

La diferencia de tiempo debemos calcularla con las Transformaciones de Lorentz, cumpliéndose:

La diferencia de tiempo debemos calcularla con las Transformaciones de Lorentz, cumpliéndose:

Observando que la diferencia de tiempo es negativa se deduce que el primer rayo cae en el punto Q.

La distancia que separa los rayos es la de la longitud del tren

La distancia que separa los rayos es la de la longitud del tren

Predicción tiene por etimología

el latín pre+dicere, esto es, “decir antes”. Una vez

Sabido el significado general,

conviene irlo afinando para ajustarlo a los usos que la

práctica demanda. Por ello, no se

trata sólo de “decir antes”, sino de “decirlo bien”, o

sea, acertar; también, hacerlo

con un plazo suficiente para poder tomar las medidas que

se crean oportunas, y además

tener una idea de hasta cuándo es posible predecir el

futuro con cierto éxito.

Cuando se efectúa una predicción,

se está estimando un valor futuro de alguna variable

que se considere representativa

de una cierta situación. Por ejemplo, en cuestiones

climáticas podría tratarse de

temperaturas medias de la atmósfera en determinados

niveles, concentraciones de

gases, precipitación, etc. También se pueden hacer

predicciones espaciales, como la

ubicación, movilidad e intensidad local de fenómenos

extremos, caso por ejemplo de los

huracanes y tormentas tropicales (Fernández &

Pacheco 2000, Pacheco & Hayek

1997). Normalmente ambos tipos de predicción están

ligados y se realizan a la vez,

como lo prueban los productos que ofrecen las grandes

agencias e institutos de

Meteorología y Climatología.

Las estimaciones realizadas para

predecir se denominan predictores. Pueden construirse

de modos muy diversos, de algunos

de los cuales nos ocuparemos en este trabajo, y su

bondad se mide -como es natural-

por el porcentaje de aciertos en situaciones del pasado

predichas con igual técnica. Las

bases de registros disponibles hoy día permiten realizar

experimentos de predecibilidad

con datos pasados y simular situaciones ya conocidas

mediante diversas técnicas,

estudiando y comparando los resultados. Es claro que para

estos experimentos la tercera

propiedad de la predicción no tiene demasiado interés,

pues la predicción -o mejor,

simulación- del pasado no incita a la prisa.

Prácticamente todos los registros

interesantes en Meteorología y Climatología se

presentan en forma de series

temporales, esto es, los datos están ordenados de forma

correlativa respecto del tiempo.

En fórmulas, se trata de trabajar con conjuntos de

valores de la forma {X t

t = 1,2,..., N}.

En esencia, el análisis de datos

temporales se reduce a encontrar pautas o patrones que

se repiten más o menos

exactamente a lo largo de ellas. Para las series meteorológicas,

por ejemplo, existe una pauta

periódica de un año que se corresponde con el periodo de

traslación de la Tierra alrededor

del Sol. Para datos tomados a intervalos muy cortos de

tiempo es posible distinguir la

pauta diaria de día/noche asociada a la rotación de la

Tierra, y varias más. Todas estas

pautas pueden ser sustraídas de la señal original

dejando un resto o residuo como

resultado de este primer análisis:

Caos

Teoría del caos es la denominación popular de la rama de las

matemáticas, la física y otras ciencias que trata ciertos tipos de sistemas

dinámicos muy sensibles a las variaciones en las condiciones iniciales.

Pequeñas variaciones en dichas condiciones iniciales pueden implicar grandes

diferencias en el comportamiento futuro; complicando la predicción a largo

plazo. Esto sucede aunque estos sistemas son en rigor determinísticos, es

decir; su comportamiento puede ser completamente determinado conociendo sus

condiciones iniciales

Popularmente, se le llama Teoría del Caos a la rama de las

ciencias exactas, principalmente física y matemáticas, que trata sobre

comportamientos impredecibles en sistemas dinámicos (sistemas complejos que

cambian o evolucionan con el estado del tiempo). La Teoría del Caos plantea que

el mundo no sigue un patrón fijo y previsible, sino que se comporta de

maneracaótica y que sus procesos y comportamiento dependen, en gran manera, de

circunstancias inciertas. Esto plantea que una pequeña variación en el sistema

o en un punto del mismo puede provocar que en un lapso de tiempo a futuro éste

presente un comportamiento completamente diferente e impredecible.

No es propiamente una teoría, sino un

gran campo de investigación abierto que abarca numerosas líneas de pensamiento.

Núcleo atómico

El núcleo atómico es la parte central de un átomo, tiene carga positiva, y concentra más del 99,9% de la masa total del átomo.

Está formado por protones y neutrones (denominados nucleones) que se mantienen unidos por medio de la interacción nuclear fuerte, la cual permite que el núcleo sea estable, a pesar de que los protones se repelen entre sí (como los polos iguales de dos imanes). La cantidad de protones en el núcleo (número atómico), determina el elemento químico al que pertenece. Los núcleos atómicos no necesariamente tienen el mismo número de neutrones, ya que átomos de un mismo elemento pueden tener masas diferentes, es decir son isótopos del elemento.

La existencia del núcleo atómico fue deducida del experimento de Rutherford, donde se bombardeó una lámina fina de oro con partículas alfa, que son núcleos atómicos de helio emitidos por rocas radiactivas. La mayoría de esas partículas traspasaban la lámina, pero algunas rebotaban, lo cual demostró la existencia de un minúsculo núcleo atómico.

El descubrimiento de los electrones fue la primera indicación de la estructura interna de los átomos. A comienzos del siglo XX el modelo aceptado del átomo era el de JJ Thomson "pudín de pasas" modelo en el cual el átomo era una gran bola de carga positiva con los pequeños electrones cargados negativamente incrustado dentro de la misma. Por aquel entonces, los físicos habían descubierto también tres tipos de radiaciones procedentes de los átomos : alfa, beta y radiación gamma. Los experimentos de 1911 realizados por Lise Meitner y Otto Hahn, y por James Chadwick en 1914 mostraron que el espectro de decaimiento beta es continuo y no discreto. Es decir, los electrones son expulsados del átomo con una gama de energías, en vez de las cantidades discretas de energía que se observa en rayos gamma y decaimiento alfa. Esto parecía indicar que la energía no se conservaba en estos decaimiento. Posteriormente se descubrió que la energía sí se conserva, con el descubrimiento de los neutrinos.

En 1906 Ernest Rutherford publicó "El retraso de la partícula alfa del radio cuando atraviesa la materia", en Philosophical Magazine (12, p. 134-46). Hans Geiger amplió este trabajo en una comunicación a la Royal Society (Proc. Roy. Soc. 17 de julio de 1908) con experimentos y Rutherford se había hecho pasar aire a través de las partículas α, papel de aluminio y papel de aluminio dorado. Geiger y Marsden publicaron trabajos adicionales en 1909 (Proc. Roy. Soc. A82 p. 495-500) y ampliaron aún más el trabajo en la publicación de 1910 por Geiger (Proc. Roy. Soc. Febrero 1, 1910). En 1911-2 Rutherford explicó ante la Royal Society los experimentos y propuso la nueva teoría del núcleo atómico.

Por esas mismas fechas (1909) Ernest Rutherford realizó un experimento en el que Hans Geiger y Ernest Marsden, bajo su supervisión dispararon partículas alfa (núcleos de helio) en una delgada lámina de oro. El modelo atómico de Thomson predecía que la de las partículas alfa debían salir de la lámina con pequeñas desviaciones de sus trayectorias están. Sin embargo, descubrió que algunas partículas se dispersan a grandes ángulos, e incluso completamente hacia atrás en algunos casos. Este descubrimiento en 1911, llevó al modelo atómico de Rutherford, en que el átomo está constituido por protones y electrones. Así, el átomo del nitrógeno-14 estaría constituido por 14 protones y 7 electrones.

El modelo de Rutherford funcionó bastante bien hasta que los estudios llevadas a cabo por Franco Rasetti, en el Institute of Technology de California en 1929. En 1925 se sabía que los protones y electrones tiene un espín de 1 / 2, y en el modelo de Rutherford nitrógeno - 14 los 14 protones y seis de los electrones deberían cancelar sus contribuciones al espín total, estimándose un espín total de 1 / 2. Rasetti descubierto, sin embargo, que el nitrógeno - 14 tiene un espín total unidad.

En 1930 Wolfgang Pauli no pudo asistir a una reunión en Tubinga, y en su lugar envió una carta famoso con la clásica introducción "Queridos Señoras y señores radiactivos ". En su carta Pauli sugirió que tal vez existía una tercera partícula en el núcleo, que la bautizó con el nombre de "neutrones". Sugirió que era más ligero que un electrón y sin carga eléctrica, y que no interactuaba fácilmente con la materia (y por eso todavía no se le había detectado). Esta hipótesis permitía resolver tanto el problema de la conservación de la energía en la desintegración beta y el espín de nitrógeno - 14, la primera porque los neutrones llevaban la energía no detectada y el segundo porque un electrón extra se acoplaba con el electrón sobrante en el núcleo de nitrógeno - 14 para proporcionar un espín de 1. Enrico Fermi redenominó en 1931 los neutrones de Pauli como neutrinos (en italiano pequeño neutral) y unos treinta años después se demostró finalmente que un neutrinos realmente se emiten en el decaimiento beta.

En 1932 James Chadwick se dio cuenta de que la radiación que de que había sido observado por Walther Bothe, Herbert L. Becker, Irène y Jean Frédéric Joliot-Curie era en realidad debido a una partículas que él llamó el neutrón. En el mismo año Dimitri Ivanenko sugirió que los neutrones eran, de hecho partículas de espín 1 / 2, que existían en el núcleo y que no existen electrones en el mismo, y Francis Perrin sugirió que los neutrinos son partículas nucleares, que se crean durante el decaimiento beta. Fermi publicó 1934 una teoría de los neutrinos con una sólida base teórica. En el mismo año Hideki Yukawa propuso la primera teoría importante de la fuerza para explicar la forma en que el núcleo mantiene juntos

RADIOACTIVIDAD

La radiactividad

(o radioactividad) puede considerarse un fenómeno físico natural por el

cual algunos cuerpos o elementos químicos, llamados radiactivos, emiten radiaciones

que tienen la propiedad de impresionar placas fotográficas, ionizar

gases, producir fluorescencia, atravesar cuerpos opacos a la luz

ordinaria, etc.

Debido a esa capacidad, se les suele denominar radiaciones ionizantes (en contraste con las no ionizantes).

Las radiaciones emitidas pueden ser electromagnéticas, en forma de rayos X o rayos gamma, o bien corpusculares, como pueden ser núcleos de helio, electrones o positrones, protones u otras. En resumen, es un fenómeno que ocurre en los núcleos de ciertos elementos, que son capaces de transformarse en núcleos de átomos de otros elementos.

Debido a esa capacidad, se les suele denominar radiaciones ionizantes (en contraste con las no ionizantes).

Las radiaciones emitidas pueden ser electromagnéticas, en forma de rayos X o rayos gamma, o bien corpusculares, como pueden ser núcleos de helio, electrones o positrones, protones u otras. En resumen, es un fenómeno que ocurre en los núcleos de ciertos elementos, que son capaces de transformarse en núcleos de átomos de otros elementos.

La radiactividad puede ser:

- Natural: manifestada por los isótopos que se encuentran en la

naturaleza.

- Artificial o inducida: manifestada por

los radioisótopos producidos en transformaciones artificiales.

En 1896 Henri

Becquerel descubrió que ciertas sales de uranio emiten radiaciones

espontáneamente, al observar que velaban las placas fotográficas envueltas en

papel negro. Hizo ensayos con el mineral en caliente, en frío, pulverizado,

disuelto en ácidos y la intensidad de la misteriosa radiación era siempre la

misma. Por tanto, esta nueva propiedad de la materia, que recibió el nombre de

radiactividad, no dependía de la forma física o química en la que se

encontraban los átomos del cuerpo radiactivo, sino que era una propiedad que

radicaba en el interior mismo del átomo.

Radiactividad artificial

La radiactividad artificial, también

llamada radiactividad inducida, se produce cuando se bombardean ciertos

núcleos estables con partículas apropiadas. Si la energía de estas partículas tiene

un valor adecuado, penetran el núcleo bombardeado y forman un nuevo núcleo que,

en caso de ser inestable, se desintegra después radiactivamente. Fue

descubierta por los esposos Jean Frédéric Joliot-Curie e Irène Joliot-Curie, bombardeando núcleos de boro y de aluminio con partículas

alfa. Observaron que las sustancias bombardeadas emitían radiaciones

después de retirar el cuerpo radiactivo emisor de las partículas de bombardeo.

Rayos Alfa (a)

Estos rayos están formados por partículas materiales que

presentan dos unidades de carga eléctrica positiva y cuatro unidades de masa.

Son ligeramente desviados por la acción de fuerzas magnéticas intensas. Pueden

ionizar los gases y penetrar en la materia. Son detenidos o absorbidos cuando

se pone ante ellos una lámina metálica. Su velocidad inicial varía desde 109

cm. /s hasta 2 x 109 cm. /s.

Rayos Beta (b)

Las partículas que conforman a los Rayos Beta son de una masa

menor a la de los rayos alfa y son de unidad de carga negativa. Se proyectan a

grandes velocidades, aunque ésta depende de la fuente de procedencia y en

ocasiones son emitidos a una velocidad próxima a la de la luz (3×1010 cm. /s).

Rayos Gamma (g)

Su naturaleza es diferente a los rayos alfa y beta, puesto que

no experimentan desviación ante los campos eléctricos y/o magnéticos. A pesar

de que tienen una menor longitud de onda que los rayos X, actúan como una

radiación electromagnética de igual naturaleza. Pueden atravesar láminas de

plomo y recorre grandes distancias en el aire. Su naturaleza es ondulatoria y

no tiene carga eléctrica, ni masa. Su capacidad de ionización es más débil en

comparación con los rayos alfa y beta. La fisión de núcleos pesados es un proceso exotérmico lo que supone que se liberan cantidades sustanciales de energía. El proceso genera mucha más energía que la liberada en las reacciones químicas convencionales, en las que están implicadas las cortezas electrónicas; la energía se emite, tanto en forma de radiación gamma como de energía cinética de los fragmentos de la fisión, que calentarán la materia que se encuentre alrededor del espacio donde se produzca la fisión.

La fisión se puede inducir por varios métodos, incluyendo el bombardeo del núcleo de un átomo fisionable con una partícula de la energía correcta; la otra partícula es generalmente un neutrón libre. Este neutrón libre es absorbido por el núcleo, haciéndolo inestable (a modo de ejemplo, se podría pensar en la inestabilidad de una pirámide de naranjas en el supermercado, al lanzarse una naranja contra ella a la velocidad correcta). El núcleo inestable entonces se partirá en dos o más pedazos: los productos de la fisión que incluyen dos núcleos más pequeños, hasta siete neutrones libres (con una media de dos y medio por reacción), y algunos fotones.

Los núcleos atómicos lanzados como productos de la fisión pueden ser varios elementos químicos. Los elementos que se producen son resultado del azar, pero estadísticamente el resultado más probable es encontrar núcleos con la mitad de protones y neutrones del átomo fisionado original.

Los productos de la fisión son generalmente altamente radiactivos, no son isótopos estables; estos isótopos entonces decaen, mediante cadenas de desintegración.

***Fisión fría y rotura de pares de nucleones ***

La mayor parte de las investigaciones sobre fisión nuclear se basan en la distribución de masa y energía cinética de los fragmentos de fisión. Sin embargo, esta distribución es perturbada por la emisión de neutrones por parte de los fragmentos antes de llegar a los detectores.Aunque con muy baja probabilidad, en los experimentos se han detectado eventos de fisión fría, es decir fragmentos con tan baja energía de excitación que no emiten neutrones. Sin embargo, aún en esos casos, se observa la rotura de pares de nucleones, la que se manifiesta como igual probabilidad de obtener fragmentos con número par o impar de nucleones. Los resultados de estos experimentos permiten comprender mejor la dinámica de la fisión nuclear hasta el punto de escisión, es decir, antes de que se desvanezca la fuerza nuclear entre los fragmentos.

Induciendo la fisión

La fisión nuclear de los átomos fue descubierta en 1938 por los investigadores Otto Hahn y Fritz Strassmann a partir del trabajo desarrollado por el propio Hahn junto a Lise Meitner durante años anteriores. Por este descubrimiento recibió en 1944 el Premio Nobel de química. El estudio de la fisión nuclear se considera parte de los campos de la química nuclear y la física.

- Aunque la fisión es prácticamente la desintegración de materia radiactiva, comenzada a menudo de la manera más fácil posible (inducido), que es la absorción de un neutrón libre, puede también ser inducida lanzando otras cosas en un núcleo fisionable. Estas otras cosas pueden incluir protones, otros núcleos, o aún los fotones de gran energía en cantidades muy altas (porciones de rayos gamma).

- Muy rara vez, un núcleo fisionable experimentará la fisión nuclear espontánea sin un neutrón entrante.

- Cuanto más pesado es un elemento más fácil es inducir su fisión. La fisión en cualquier elemento más pesado que el hierro produce energía, y la fisión en cualquier elemento más liviano que el hierro requiere energía. Lo contrario también es verdad en las reacciones de fusión nuclear (la fusión de los elementos más livianos que el hierro produce energía y la fusión de los elementos más pesados que el hierro requiere energía).

- Los elementos más frecuentemente usados para producir la fisión nuclear son el uranio y el plutonio. El uranio es el elemento natural más pesado; el plutonio experimenta desintegraciones espontáneas y tiene un período de vida limitado. Así pues, aunque otros elementos pueden ser utilizados, estos tienen la mejor combinación de abundancia y facilidad de fisión.

Reacción en cadenas

Una reacción en cadena ocurre como sigue: un acontecimiento de fisión empieza lanzando 2 ó 3 neutrones en promedio como subproductos. Estos neutrones se escapan en direcciones al azar y golpean otros núcleos, incitando a estos núcleos a experimentar fisión. Puesto que cada acontecimiento de fisión lanza 2 o más neutrones, y estos neutrones inducen otras fisiones, el proceso se acelera rápidamente y causa la reacción en cadena. El número de neutrones que escapan de una cantidad de uranio depende de su área superficial. Solamente los materiales fisibles son capaces de sostener una reacción en cadena sin una fuente de neutrones externa. Para que la reacción en cadena de fisión se lleve a cabo es necesario adecuarLa física (del lat. physica, y este del gr. τὰ φυσικά, neutro plural de φυσικός, "naturaleza") es la ciencia natural que estudia las propiedades y el comportamiento de la energía y la materia (como también cualquier cambio en ella que no altere la naturaleza de la misma), así como al tiempo, el espacio y las interacciones de estos cuatro conceptos entre sí.

La física es una de las más antiguas disciplinas académicas, tal vez la más antigua, ya que la astronomía es una de sus disciplinas. En los últimos dos milenios, la física fue considerada dentro de lo que ahora llamamos filosofía, química, y ciertas ramas de la matemática y la biología, pero durante la Revolución Científica en el siglo XVII surgió para convertirse en una ciencia moderna, única por derecho propio. Sin embargo, en algunas esferas como la física matemática y la química cuántica, los límites de la física siguen siendo difíciles de distinguir.

El área se orienta al desarrollo de competencias de una cultura científica, para comprender nuestro mundo físico, viviente y lograr actuar en él tomando en cuenta su proceso cognitivo, su protagonismo en el saber y hacer científico y tecnológico, como el conocer, teorizar, sistematizar y evaluar sus actos dentro de la sociedad. De esta manera, contribuimos a la conservación y preservación de los recursos, mediante la toma de conciencia y una participación efectiva y sostenida.

Mecánica clásica

La mecánica newtoniana, como su nombre indica, lleva intrínsecos los preceptos de Newton. A partir de las tres ecuaciones formuladas por Newton y mediante el cálculo diferencial e integral, se llega a una muy exacta aproximación de los fenómenos físicos. Esta formulación también es conocida como mecánica vectorial, y es debido a que a varias magnitudes se les debe definir su vector en un sistema de referencia inercial privilegiado.[8]

La mecánica analítica es una formulación matemática abstracta sobre la mecánica; nos permite desligarnos de esos sistemas de referencia privilegiados y tener conceptos más generales al momento de describir un movimiento con el uso del cálculo de variaciones. Existen dos formulaciones equivalentes: la llamada mecánica lagrangiana es una reformulación de la mecánica realizada por Joseph Louis Lagrange que se basa en la ahora llamada ecuación de Euler-Lagrange (ecuaciones diferenciales de segundo orden) y el principio de mínima acción; la otra, llamada mecánica hamiltoniana, es una reformulación más teórica basada en una funcional llamada hamiltoniano realizada por William Hamilton. En última instancia las dos son equivalentes.[8]

En la mecánica clásica en general se tienen tres aspectos invariantes: el tiempo es absoluto, la naturaleza realiza de forma espontánea la mínima acción y la concepción de un universo determinado.

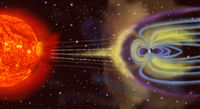

Electromagnetismo

La electrostática es el estudio de los fenómenos asociados a los cuerpos cargados en reposo. Como se describe por la ley de Coulomb, estos cuerpos ejercen fuerzas entre sí. Su comportamiento se puede analizar en términos de la idea de un campo eléctrico que rodea cualquier cuerpo cargado, de manera que otro cuerpo cargado colocado dentro del campo estará sujeto a una fuerza proporcional a la magnitud de su carga y de la magnitud del campo en su ubicación. El que la fuerza sea atractiva o repulsiva depende de la polaridad de la carga. La electrostática tiene muchas aplicaciones, que van desde el análisis de fenómenos como tormentas eléctricas hasta el estudio del comportamiento de los tubos electrónicos.

buena información, gracias por compartirla

ResponderEliminar